Depois do surgimento do ChatGPT, o mundo virou sua atenção para a rápida evolução da inteligência artificial. Todos nós ficamos impressionados com a capacidade do algoritmo de gerar textos de forma tão natural com interpretação e execução de ações.

Além da integração com sites de busca, veremos muita evolução na facilidade de utilizar a tecnologia em diversas aplicações. A dúvida que fica é até onde a IA pode chegar? O que pode (e o que não pode) ser substituído por um algoritmo?

O que é inteligência artificial?

Inteligência artificial (IA) é um campo da ciência da computação que se concentra no desenvolvimento de algoritmos e sistemas capazes de executar tarefas que normalmente requerem inteligência humana, como aprender, raciocinar, perceber, reconhecer fala, visão e linguagem natural. Em resumo, a IA permite que os computadores processem informações de maneira “inteligente” (entre aspas) e tomem decisões com base em dados.

Essa “inteligência” é obtida através de uma grande quantidade de dados que são treinados e aumentam a capacidade de decisão. Assim, para entender onde isso tudo pode parar (ou não), é necessário saber como os dados são processados e usados.

O que é “GPT”? (Generative Pre-trained Transformer)

GPT é um modelo de linguagem pré-treinado que usa a arquitetura Transformer, introduzido pelo Google em 2017, para gerar texto. O GPT-3, que é usado pelo ChatGPT, foi lançado em 2020 é a terceira versão do modelo e a mais poderosa até o momento.

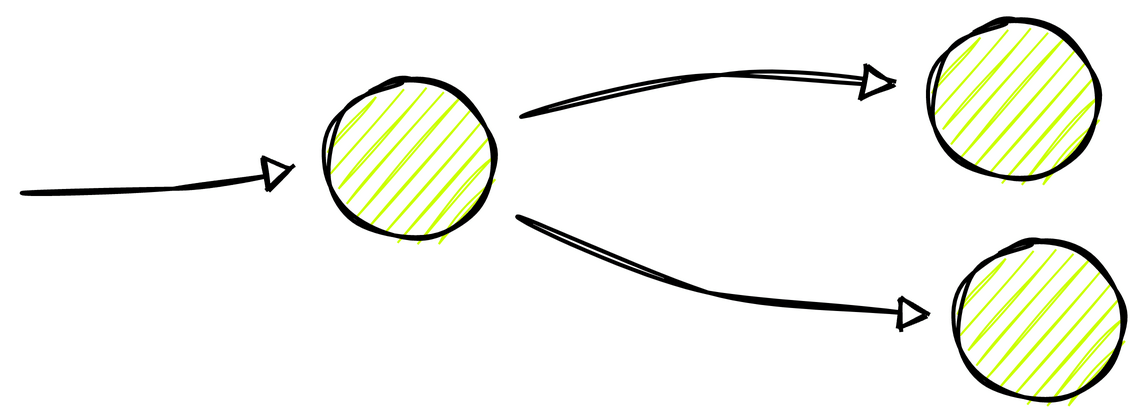

O treinamento é feito através de uma “rede neural” que funciona como se fossem neurônios isolados. Durante o aprendizado, um neurônio recebe dados e faz os cálculos jogando uma saída para os neurônios do próximo nível. Dentro de cada neurônio são realizados cálculos ajustados com os parâmetros.

Cada versão do GPT teve a sua definição de parâmetros e conexões entre eles. Os parâmetros são como ingredientes de uma receita que podem influenciar o resultado final como cor, textura, gosto, temperatura, etc… Já as conexões são a forma de interação entre os parâmetros e o ajuste dessas dessas combinações levam a um resultado final mais (ou menos) assertivo.

Veja a diferença de evolução das diferentes versões do GPT.

- GPT-1: 117 milhões de parâmetros

- GPT-2: 1,2 bilhões de parâmetros

- GPT-3: 175 bilhões de parâmetros

Conforme aumenta a complexidade, é exigido muito mais capacidade de processamento dificultando, inclusive, o treinamento incremental com novos dados. Por este motivo, o ChatGPT foi treinado apenas uma vez com dados de até 2021.

O GPT é totalmente voltado para a geração de texto com cálculo de probabilidades de quais serão as próximas palavras a serem inseridas. A escolha da próxima palavra depende do contexto anterior, repetição, entre muitas outras variáveis.

Limitações do GPT

- Pré-treinamento: Uma vez treinado, o sistema consegue gerar informações a partir do conteúdo que foi inserido mas não conseguirá considerar informações novas. O treinamento incremental é possível, ainda não é usado no ChatGPT em novas conversas.

- Limite dos dados de entrada: A arquitetura tem um limite de dados de entrada de 2048 tokens (palavras completas ou pedaços). Isso significa que não é possível entrar com uma grande quantidade de dados e isso pode limitar algumas aplicações.

- Viés: Se o modelo é treinado com dados de apeanas uma fonte, ele pode ter um viés. Este é um grande problema que pode gerar conclusões erradas, preconceitos ou até opinar sobre temas polêmicos. Assim, exige um treinamento adicional de fontes diferentes ou de dados coletados manualmente para aprimorar o modelo.

- Tempo de inferência: O tempo de inferência é o tempo que o modelo leva para gerar a resposta. O GPT-3 acaba demorando muito para gerar um resultado, o que também pode ser problema para algumas aplicações.

Certamente, existem outras limitações como o custo de processamento e a capacidade de atualização dos dados.

Onde a inteligência atificial pode chegar?

Existem rumores que o GPT-4 será lançado em 2023 e terá alguns trilhões de parâmetros capazes de produzir textos ainda mais assertivos e muito mais longos, além da entrada com mais tokens.

Devemos ver mais evolução em “Multimodal”, ou seja, a capacidade de processar (e gerar) dados de diferentes fontes como texto, imagem, áudio, vídeo, etc… O DALL-E é um bom exemplo de multimodal AI que consegue gerar imagens a partir de textos, também da OpenAI.

O termo GPT se popularizou muito nas últimas semanas mas existem conceitos muito mais avançados como o AGI (Artificial General Intelligence) que é a capacidade de um sistema de processar e aprender dados de forma semelhante a um ser humano. O AGI é um conceito muito mais amplo e complexo que o GPT e pode demorar alguns (poucos) anos para vermos algo mais próximo disso.